Mistral 发布首个面向代码开发的大模型

- 发表于

- 人工智能

Mistral 大模型 Codetral 22B

Codestral 是一个专为生成代码而设计的 AI 模型,它精通代码和英语,可以被用来为软件开发人员设计先进的 AI 应用程序。你可以通过VSCODE扩展快速试用。

- Codestral 22B 掌握 80 多种编程语言,如 Python,Java,C,C++, JavaScript 和 Bash等。

- Codestral 22B 在六种主流语言的 Humaneval (用于评估编程语言模型的基准测试工具) 的平均测试结果优于 CodeLlama 70B 和 DeepSeek Coder 33B, 比 Llama-3-70B 略高。 其中 Python 代码生成能力比起其他模型表现突出。(见下图)

- 当前 Codetral 22B 的 License 为 MNPL(非生产许可证), 只可将其用于研究和测试目的。

- Codestral 22B 现可通过 HuggingFace 或 Ollama 下载使用。

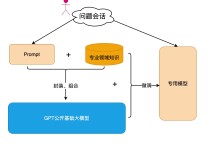

Mixtral 8x22B 具有以下优点:

- 它精通英语、法语、意大利语、德语和西班牙语

- 它具有很强的数学和编码能力

- 它本身就能够调用函数;再加上在 la Plateforme 上实现的受限输出模式,这实现了大规模的应用程序开发和技术堆栈现代化

- 其 64K 令牌上下文窗口允许从大型文档中精确调用信息

真正开放

我们相信开放和广泛分布的力量可以促进人工智能的创新和协作。

因此,我们在 Apache 2.0 下发布了 Mixtral 8x22B,这是最宽松的开源许可证,允许任何人在任何地方不受限制地使用该模型。

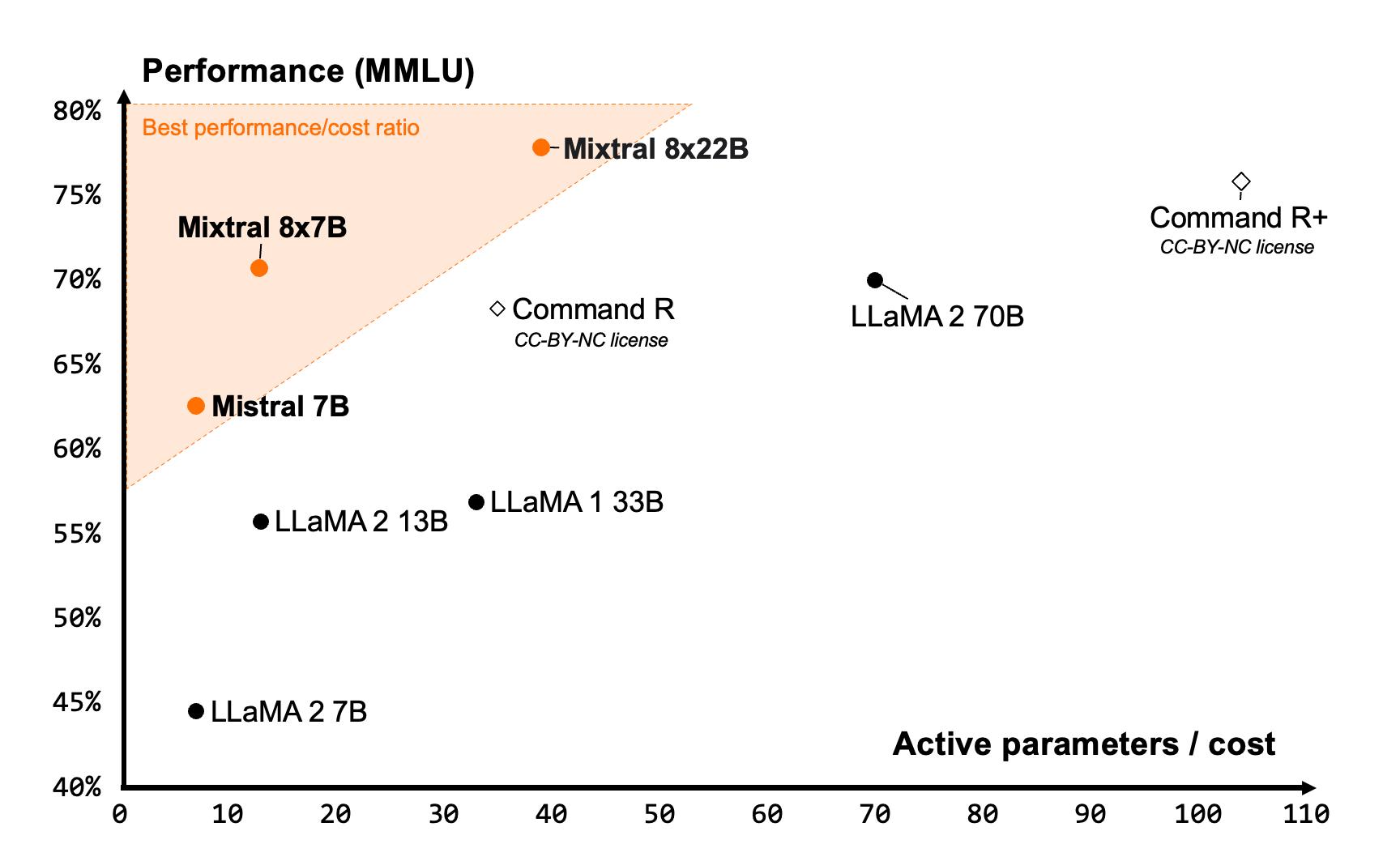

效率极致

我们构建的模型为各自的尺寸提供无与伦比的成本效益,在社区提供的模型中提供最佳的性价比。

Mixtral 8x22B 是我们开放式型号系列的自然延续。其稀疏的激活模式使其比任何密集的 70B 模型都快,同时比任何其他开放重量模型(在许可或限制许可下分发)更强大。基本模型的可用性使其成为微调用例的绝佳基础。

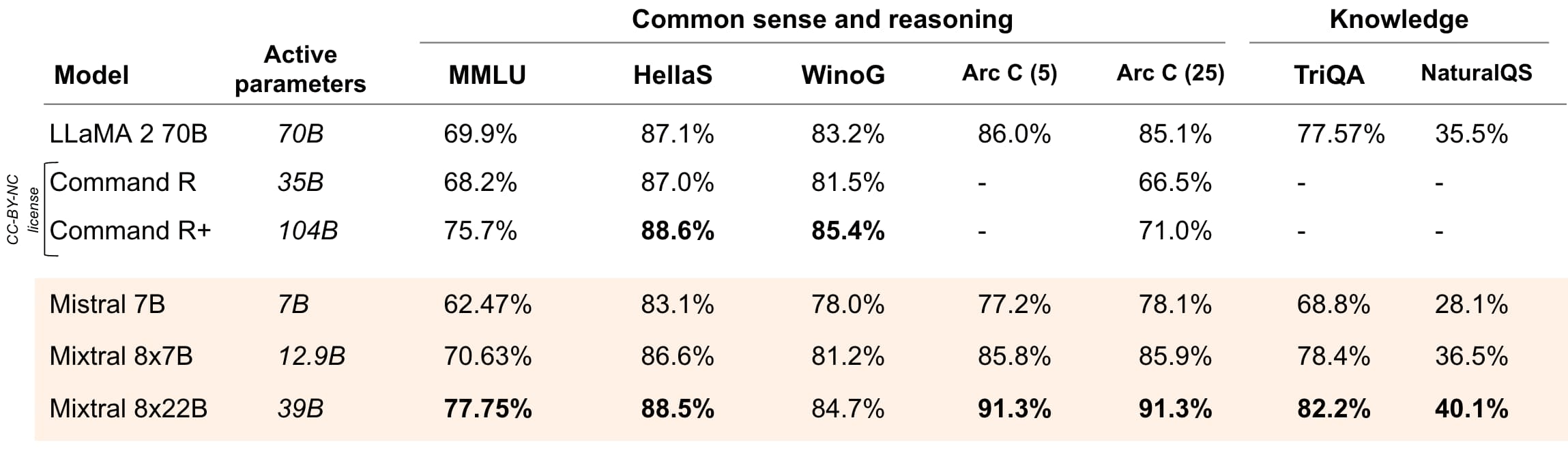

推理和知识

Mixtral 8x22B 针对推理进行了优化。

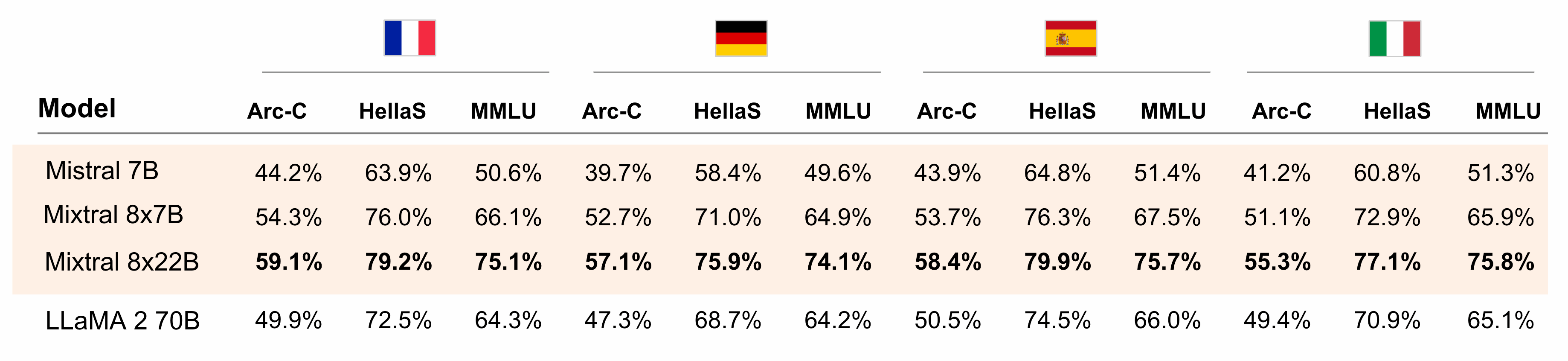

多语言能力

Mixtral 8x22B 具有原生多语言功能。它在法语、德语、西班牙语和意大利语的 HellaSwag、Arc Challenge 和 MMLU 基准测试中表现优于 LLaMA 2 70B。

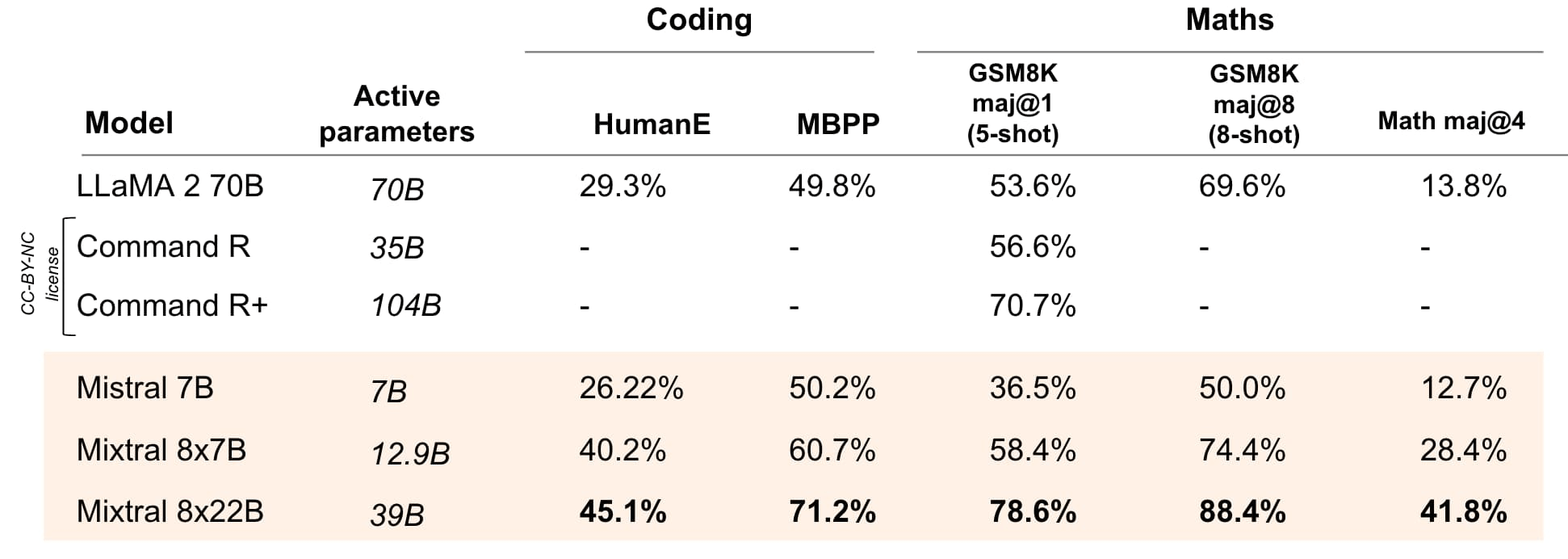

数学与编码

与其他开放模型相比,Mixtral 8x22B 在编码和数学任务中表现最佳。

图 4:领先的开放模型在流行的编码和数学基准测试中的表现:HumanEval pass@1、MBPP pass@1、GSM8K maj@1(5 次)、GSM8K maj@8(8 次)和 Math maj@4。

今天发布的 Mixtral 8x22B 的指示版本显示出更好的数学性能,GSM8K maj@8 得分为 90.8%,数学maj@4得分为 44.6%。

原文连接:Mistral 发布首个面向代码开发的大模型

所有媒体,可在保留署名、

原文连接的情况下转载,若非则不得使用我方内容。