cnn_captcha 字符型图片验证码识别

本项目针对字符型图片验证码,使用tensorflow实现卷积神经网络,进行验证码识别。项目封装了比较通用的校验、训练、验证、识别、API模块,极大的减少了识别字符型验证码花费的时间和精力。

验证码识别大多是爬虫会遇到的问题,也可以作为图像识别的入门案例。目前通常使用如下几种方法:

| 方法名称 | 相关要点 |

|---|---|

| tesseract | 仅适合识别没有干扰和扭曲的图片,训练起来很麻烦 |

| 其他开源识别库 | 不够通用,识别率未知 |

| 付费OCR API | 需求量大的情形成本很高 |

| 图像处理+机器学习分类算法 | 涉及多种技术,学习成本高,且不通用 |

| 卷积神经网络 | 一定的学习成本,算法适用于多类验证码 |

这里说一下使用传统的图像处理和机器学习算法,涉及多种技术:

图像处理

- 前处理(灰度化、二值化)

- 图像分割

- 裁剪(去边框)

- 图像滤波、降噪

- 去背景

- 颜色分离

- 旋转

机器学习

- KNN

- SVM

使用这类方法对使用者的要求较高,且由于图片的变化类型较多,处理的方法不够通用,经常花费很多时间去调整处理步骤和相关算法。

而使用卷积神经网络,只需要通过简单的前处理,就可以实现大部分静态字符型验证码的端到端识别,效果很好,通用性很高。

cnn_captcha 安装

git clone https://github.com/nickliqian/cnn_captcha.git

pip install -r requirements.txt注意:如果需要使用GPU进行训练,请把文件中的tenforflow修改为tensorflow-gpu

模型结构

| 序号 | 层级 |

|---|---|

| 输入 | input |

| 1 | 卷积层 + 池化层 + 降采样层 + ReLU |

| 2 | 卷积层 + 池化层 + 降采样层 + ReLU |

| 3 | 卷积层 + 池化层 + 降采样层 + ReLU |

| 4 | 全连接 + 降采样层 + Relu |

| 5 | 全连接 + softmax |

| 输出 | output |

cnn_captcha 使用

数据集

原始数据集可以存放在./sample/origin目录中。

为了便于处理,图片最好以2e8j_17322d3d4226f0b5c5a71d797d2ba7f7.jpg格式命名(标签_序列号.后缀)。

如果你没有训练集,你可以使用gen_sample_by_captcha.py文件生成训练集文件。 生成之前你需要修改相关配置conf/captcha_config.json(路径、文件后缀、字符集等)。

{

"root_dir": "sample/origin/",# 验证码保存路径

"image_suffix": "png", # 验证码图片后缀

"characters": "0123456789",# 生成验证码的可选字符

"count": 1000, # 生成验证码的图片数量

"char_count": 4, # 每张验证码图片上的字符数量

"width": 100,# 图片宽度

"height": 60 # 图片高度

}配置文件

创建一个新项目前,需要自行修改相关配置文件conf/sample_config.json。

{

"origin_image_dir": "sample/origin/",# 原始文件

"new_image_dir": "sample/new_train/",# 新的训练样本

"train_image_dir": "sample/train/",# 训练集

"test_image_dir": "sample/test/",# 测试集

"api_image_dir": "sample/api/",# api接收的图片储存路径

"online_image_dir": "sample/online/",# 从验证码url获取的图片的储存路径

"local_image_dir": "sample/local/",# 本地保存图片的路径

"model_save_dir": "model/",# 从验证码url获取的图片的储存路径

"image_width": 100,# 图片宽度

"image_height": 60,# 图片高度

"max_captcha": 4,# 验证码字符个数

"image_suffix": "png", # 图片文件后缀

"char_set": "0123456789abcdefghijklmnopqrstuvwxyz",# 验证码识别结果类别

"use_labels_json_file": false, # 是否开启读取`labels.json`内容

"remote_url": "http://127.0.0.1:6100/captcha/",# 验证码远程获取地址

"cycle_stop": 3000,# 启动任务后的训练指定次数后停止

"acc_stop": 0.99,# 训练到指定准确率后停止

"cycle_save": 500, # 训练指定次数后定时保存模型

"enable_gpu": 0, # 是否开启GUP训练

"train_batch_size": 128, # 训练时每次使用的图片张数,如果CPU或者GPU内存太小可以减少这个参数

"test_batch_size": 100 # 每批次测试时验证的图片张数,不要超过验证码集的总数

}关于验证码识别结果类别,假设你的样本是中文验证码,你可以使用tools/collect_labels.py脚本进行标签的统计。 会生成文件gen_image/labels.json存放所有标签,在配置文件中设置use_labels_json_file = True开启读取labels.json内容作为结果类别。

验证和拆分数据集

此功能会校验原始图片集的尺寸和测试图片是否能打开,并按照19:1的比例拆分出训练集和测试集。

所以需要分别创建和指定三个文件夹:origin,train,test用于存放相关文件。

也可以修改为不同的目录,但是最好修改为绝对路径。

文件夹创建好之后,执行以下命令即可:

python3 verify_and_split_data.py一般会有类似下面的提示

>>> 开始校验目录:[sample/origin/]

开始校验原始图片集

原始集共有图片: 1001张

====以下1张图片有异常====

[第0张图片] [.DStore] [文件后缀不正确]

========end

开始分离原始图片集为:测试集(5%)和训练集(95%)

共分配1000张图片到训练集和测试集,其中1张为异常留在原始目录

测试集数量为:50

训练集数量为:950

>>> 开始校验目录:[sample/new_train/]

【警告】找不到目录sample/new_train/,即将创建

开始校验原始图片集

原始集共有图片: 0张

====以下0张图片有异常====

未发现异常(共 0 张图片)

========end

开始分离原始图片集为:测试集(5%)和训练集(95%)

共分配0张图片到训练集和测试集,其中0张为异常留在原始目录

测试集数量为:0

训练集数量为:0

程序会同时校验和分割origin_image_dir和new_image_dir两个目录中的图片;后续有了更多的样本,可以把样本放在new_image_dir目录中再次执行verify_and_split_data。

程序会把无效的文件留在原文件夹。

此外,当你有新的样本需要一起训练,可以放在sample/new目录下,再次运行python3 verify_and_split_data.py即可。

需要注意的是,如果新的样本中有新增的标签,你需要把新的标签增加到char_set配置中或者labels.json文件中。

训练模型

创建好训练集和测试集之后,就可以开始训练模型了。

训练的过程中会输出日志,日志展示当前的训练轮数、准确率和loss。

此时的准确率是训练集图片的准确率,代表训练集的图片识别情况

例如:

第10次训练 >>>

[训练集] 字符准确率为 0.03000 图片准确率为 0.00000 >>> loss 0.1698757857

[验证集] 字符准确率为 0.04000 图片准确率为 0.00000 >>> loss 0.1698757857字符准确率和图片准确率的解释:

假设:有100张图片,每张图片四个字符,共400个字符。我们这里把任务拆分为为需要识别400个字符

字符准确率:识别400的字符中,正确字符的占比。

图片准确率:100张图片中,4个字符完全识别准确的图片占比。这里不具体介绍tensorflow安装相关问题,直奔主题。

确保图片相关参数和目录设置正确后,执行以下命令开始训练:

python3 train_model.py也可以根据train_model.py的main函数中的代码调用类开始训练或执行一次简单的识别演示。

由于训练集中常常不包含所有的样本特征,所以会出现训练集准确率是100%而测试集准确率不足100%的情况,此时提升准确率的一个解决方案是增加正确标记后的负样本。

批量验证

使用测试集的图片进行验证,输出准确率。

python3 test_batch.py同样可以根据main函数中的代码调用类开始验证。

启动WebServer

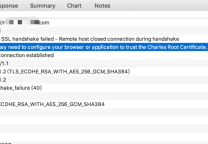

项目已经封装好加载模型和识别图片的类,启动web server后调用接口就可以使用识别服务。

启动web server

python3 webserver_recognize_api.py接口url为http://127.0.0.1:6000/b

调用接口识别

使用requests调用接口:

url = "http://127.0.0.1:6000/b"

files = {'image_file': (image_file_name, open('captcha.jpg', 'rb'), 'application')}

r = requests.post(url=url, files=files)返回的结果是一个json:

{

'time': '1542017705.9152594',

'value': 'jsp1',

}文件recognize_local.py是使用接口识别本地的例子,这个例子运行成功,那么识别验证码的一套流程基本上是走了一遍了。

在线识别验证码是显示中常用场景,文件recognize_online.py是使用接口在线识别的例子,参见:## 2.11 在线识别。

部署

部署的时候,把webserver_recognize_api.py文件的最后一行修改为如下内容:

app.run(host='0.0.0.0',port=5000,debug=False)然后开启端口访问权限,就可以通过外网访问了。

另外为了开启多进程处理请求,可以使用uwsgi+nginx组合进行部署。

这部分可以参考:Flask部署选择

部署多个模型

部署多个模型: 在webserver_recognize_api.py文件汇总,新建一个Recognizer对象;

并参照原有up_image函数编写的路由和识别逻辑。

Q = Recognizer(image_height, image_width, max_captcha, char_set, model_save_dir)注意修改这一行:

value = Q.rec_image(img)在线识别

在线识别验证码是显示中常用场景,即实时获取目标验证码来调用接口进行识别。

为了测试的完整性,这里搭建了一个验证码获取接口,通过执行下面的命令启动:

python webserver_captcha_image.py启动后通过访问此地址:http://127.0.0.1:6100/captcha/可以接收到验证码图片的二进制流文件。

具体进行在线识别任务的demo参见:recognize_online.py。

原文连接的情况下转载,若非则不得使用我方内容。